Um ano de GPT-3, a IA que se comunica (e até codifica) como humano

Lançado em maio de 2020, modelo desperta fascínio e dúvidas, rendeu inúmeros experimentos na web e pode ter aberto portas a uma nova era na comunicação entre humanos e máquinas

O trabalho de profissionais de conteúdo, do Direito ou mesmo de desenvolvedores de software (quem sabe até de data scientists) estaria ameaçado? Ou é só hype, os custos serão proibitivos à maioria das empresas e logo surgirão regulamentações para preservar empregos? Ou melhor: vamos nos livrar de vez de trabalho repetitivo e enfadonho para flanar entre ideias, tendo tempo para a criação, os jogos e a convivência?

O GPT-3 (Generative Pre-trained Transformer 3)1, o mais poderoso modelo de geração de linguagem natural já criado, que completou um ano recentemente2, já levantou todas essas questões e deve continuar motivando entusiasmo e preocupação, principalmente a partir do momento em que começar a ser usado em produção no mercado. Para publicações como a The Verge, por exemplo, a invenção pode “acabar definindo a próxima década”.

Em termos de máquina, o GPT-3 é considerado, de fato, o modelo mais avançado na classe do processamento de linguagem natural (NLP, de Natural Language Processing, em inglês).

Em sua versão mais completa, esse sistema de deep learning, baseado em aprendizado não supervisionado, foi treinado com base em 175 bilhões de parâmetros. Para comparação, seu antecessor, o GPT-2, de fevereiro de 2019, lida com 1,5 bilhões de parâmetros, e o Turing NLG da Microsoft, de fevereiro de 2020, até então o mais avançado, com 17 bilhões.

Os dados de treinamento foram nada menos que 45 terabytes de texto da web ou 499 bilhões de palavras, em um supercomputador de Inteligência Artificial (IA) da Azure, da Microsoft.

A proeza envolveu uma equipe de 31 engenheiros, durante um ano, a um custo estimado de US$ 4,6 milhões, embora haja comentários de que custos globais teriam chegado a US$ 12 milhões3 ― um valor ou outro, definitivamente não é brincadeira para amadores.

E isso tudo é só maquinaria. O que interessa mesmo é a capacidade do modelo em imitar seres humanos de forma bastante crível, seja na escrita ou na resposta a perguntas.

É um feito tecnológico considerável e um desses assuntos misteriosos e empolgantes para quem se interessa por Ciência de Dados e aprendizado de máquina — embora, sejamos francos, mais empolgante mesmo seria trabalhar na criação de uma ferramenta dessas e não ficar apenas na camada de uso, mas é o que nos resta por enquanto.

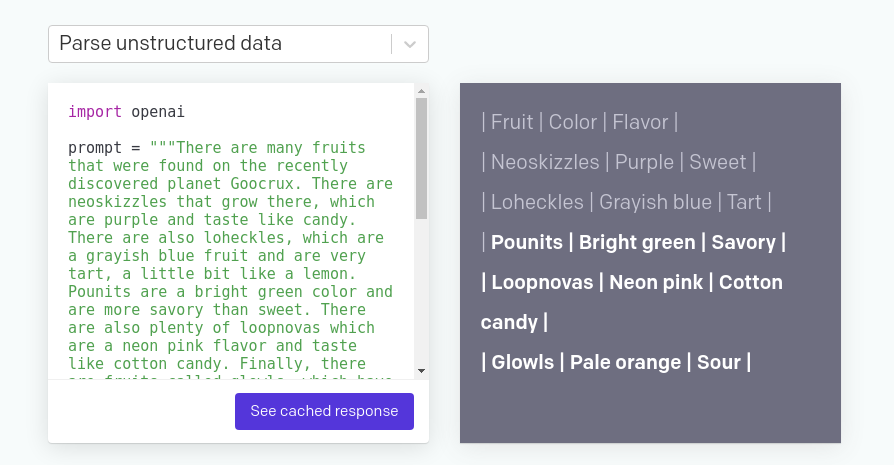

Para entender o poder do algoritmo, basta saber que o GPT-3 é capaz de criar texto de saída com bastante precisão e velocidade em resposta a qualquer texto mínimo de entrada. Isto é, dada uma determinada pergunta, o modelo processa uma resposta. Ou dada uma determinada introdução, o modelo elabora um texto completo. Ou, ainda, dada uma instrução computacional bastante resumida, o GPT-3 devolve um código pronto em uma determinada linguagem de programação.

Os relatos de quem testou a novidade demonstram que há casos que se assemelham a “magia” ― uma resposta muito precisa entregue à primeira instrução dada ―, enquanto outras tentativas que requerem um certo talento (e paciência) na inserção das entradas, até que o modelo aprimore a saída.

Exemplo hipotético (o GPT-3 provavelmente acertaria de primeiro por se tratar de algo preciso): para um “10 + 10” a máquina poderia, em um primeiro momento, confundir-se. Mas dado um “se 10 + 10 = 20, então 20 + 20...”, responderia corretamente, e cada vez mais corretamente à medida que mais aprendesse tal padrão.

Como o GPT-3 foi treinado com textos da web, que vão desde conteúdos sérios e criteriosos a referências da cultura pop, há respostas que entregam todas as nuances dessas referências.

Para alguns domínios, retorna saídas bastante exatas, como a em que, dada uma descrição textual de uma equação, recupera e entrega a fórmula da mesma. Ou, para comemoração ou preocupação de desenvolvedores e cientistas de dados, o seguinte caso: você instrui à máquina algo como “construir um modelo no Keras para classificar imagens, sendo que o dataset contém 25.000 imagens”. E o GPT-3 entrega o código pronto.

Também há casos que podem ser engraçados, na medida em que as entradas informadas saem de domínios mais precisos, sobretudo os mais filosóficos (vale sempre lembrar: o GPT-3 foi treinada com o que nós, como humanidade, já sabemos e criamos, e seria sobrenatural demais ela ter a capacidade de responder perguntas às quais nem nós temos resposta).

Para a entrada “resposta à questão fundamental da vida, do universo e de tudo que existe”, o GPT-3 pode responder, em um primeiro lance, “quarenta”. Acrescentando-se o termo à primeira pergunta e submetendo-o novamente, emenda, então: “e dois”. Ou seja, para o modelo, o sentido da vida, do universo e de tudo que existe é “quarenta e dois”, uma clara referência a “O Guia do Mochileiro das Galáxias”, de Douglas Adams, em que 42 é a resposta “à vida, ao universo e tudo mais”. Cultura pop e não filosofia, em resumo.

No paper que documenta a criação, está explícito que “o GPT-3 pode gerar amostras de artigos de notícias que avaliadores humanos teriam dificuldade para distinguir de artigos escritos por humanos”.

Foi o que o estudante Liam Porr testou na prática, com interessante êxito ― e esse é um dos aspectos do modelo que pode preocupar, em termos de mercado de trabalho e de criação de boatos, como discorreremos adiante.

Liam criou um blog, o Adolos, em que se propôs a escrever título e introdução, adicionar uma foto a posts e deixar o GPT-3 fazer o restante, ou seja, escrever cada um dos textos.

A primeira postagem chegou ao primeiro lugar no Hacker News, como a Harvard Business Review ― ou seja, seres humanos gostaram do que a máquina estava escrevendo, sem saber que se tratava de uma máquina (pode-se ver isto nos comentários). Em duas semanas, o blog teve 26 mil visitantes e 60 assinantes fiéis, segundo Liam.

Até o estudante revelar o que estava ocorrendo, apenas uma pessoa havia perguntado se um dos textos, por acaso, tinha a “criatividade” do GPT-3 envolvida. (No próprio paper do GPT-3, os engenheiros também demonstram um exemplo de texto de difícil distinção, que ainda não passa no Teste de Turing, mas chega perto).

O próprio jeito com que Liam conseguiu acesso à API do GPT-3 mostra como inovações desse tipo, com consequências desconhecidas, podem acabar caindo em “mãos erradas” da forma que menos se imagina.

O autor do blog é um estudante de ciência da computação da Universidade da Califórnia, em Berkeley. Como estudante, não tinha acesso à API, a interface de código que permitia utilizar o algoritmo até julho de 2020, em fase beta. O acesso foi reservado a empresas como Algolia, Quizlet e Reddit e pesquisadores ligados a instituições como Middlebury Institute, segundo a OpenAI.

Pois Liam negociou com um pesquisador PhD, que possuía a permissão, para utilizar o modelo. Como naqueles casos em que um adolescente consegue hackear o iPhone logo após ser lançado, estava aberta a porta para um primeiro teste real da ferramenta e um alerta sobre suas consequências.

A OpenAI decidiu manter a API em versão beta limitada após a apresentação do modelo justamente por segurança, para que, segundo ela, “parceiros acadêmicos testem e avaliem suas capacidades e limitações”.

Outros exemplos, de cômicos a sérios e de poéticos a preocupantes, continuam surgindo na internet um ano depois. O portal brasileiro Canal Tech, com ajuda de um programador, também brasileiro, que teve acesso à API, fez um exercício interessante: pediu ao GPT-3 para criar um texto sobre fake news, outro sobre “Elon Musk, Grimes e o bebê” (uma fofoca da internet), outro sobre 5G no Brasil (motivo de briga geopolítica entre EUA e China e alvo de teorias da conspiração durante a Covid) e um quarto sobre a própria pandemia. Teve até música do Wando no final. Os resultados falam por si, sobre as capacidades e deficiências que a API apresenta.

Para quem não conhece, a OpenAI é uma instituição sem fins lucrativos especializada em inteligência artificial sediada em São Francisco, Califórnia, que tem como investidores, entre outros, a Microsoft, a qual em setembro de 2020 anunciou o licenciamento exclusivo do GPT-3.

A OpenAI destaca que sua missão, bastante ambiciosa, é “garantir que a inteligência geral artificial (o que significa sistemas altamente autônomos, que superam humanos em trabalhos economicamente valiosos) beneficie toda a humanidade”.

Sua Carta Aberta descreve a missão e vários princípios e as preocupações com usos inadequados da ferramenta estão explícitas tanto em textos da própria OpenAI quanto no paper de apresentação do GPT-3.

Fim de profissionais de conteúdo e até de programadores?

Uma das primeiras grandes reflexões que surgem a partir da capacidade e versatilidade do super modelo é em relação aos possíveis impactos no mundo do trabalho, como levantado por Liam no próprio Adolos.

É fácil cair em futurologia barata ou ficção científica ao se falar de “Inteligência Artificial” demitindo uma legião de “operários” e gerando muita confusão, similar ao avanço do Uber e dos consequentes protestos de taxistas mundo afora.

Mas o GPT-3 realmente é diferenciado nos impactos que pode causar. A novidade, agora, é que não estamos mais falando de trabalho braçal ou mecânico, que já vem sendo substituído rotineiramente desde que caras como John Deere criaram as primeiras colheitadeiras, nos EUA, no século XIX.

Estamos tratando de trabalho criativo, ou, pelo menos, de uma camada dele que emprega milhares ou milhões de trabalhadores em diversos ramos, como mídia e comunicação, Direito, arte e desenvolvimento de software.

Obviamente, em ramos maduros e bem regulamentados como o Direito novidades desse tipo devem ser implantadas com muito mais cautela e, imagina-se, resistência corporativa. Prevê-se que a aplicação de um GPT-3 no ramo poderia ser a geração de bases de textos já padronizados, que depois seriam lapidados por humanos.

De qualquer forma, isso poderia enxugar uma boa quantidade de escrivães braçais em comarcas, fóruns, escritórios de advocacia, cartórios e similares. A administração pública, baseada em modelos de documentos administrativos, também poderia ser afetada da mesma maneira.

No desenvolvimento de software, é imaginável que tal tecnologia faria um papel de auxiliar virtual do programador. Em 2021, a Microsoft anunciou a primeira experiência em produção nesse sentido: integrou o GPT-3 ao Microsoft Power Apps, plataforma para “desenvolvedores cidadãos” (algo no-code ou low-code4), que ajudará na geração de trechos de código.

Aqui, também poderia eliminar força de trabalho, principalmente de iniciantes em empresas e departamentos mais tradicionais, ainda hoje voltados a tarefas de codificação repetitiva, como criação de telas, relatórios, formulários e rotinas de banco de dados e infraestrutura ― embora seja curioso pensar como engenheiros, principalmente seniores, reagiriam à automatização criada por expertise de sua própria categoria.

Agora, em mídia e comunicação, o impacto pode ser fortíssimo. Na mídia jornalística, embora reportagens investigativas e “furos” (notícias exclusivas) possam escapar de um GPT-3 ― a menos que ela ganhe o poder de olhar para o mundo real e descrevê-lo, o que seria assustador demais ―, tal tecnologia poderia avançar em “notícias commodities”, como aquelas sobre resultados de futebol e outros esportes, sobre variações da bolsa de valores ou sobre a agenda do governo.

Os chatbots, também, estariam provavelmente no suprassumo das demandas. Pense-se em um aplicativo de entrega de comidas sendo operado não mais por meio de um site ou aplicativo, com base em regras, mas com solicitações que chegam via voz, por WhatsApp ou Telegram, completamente desestruturadas, e que um GPT-3 entende, converte em uma lista de pedidos (ou de ingredientes) e repassa à cozinha de restaurantes.

Mas, ainda falando de mídia, é na produção de conteúdo para blogs, e-books e toda a cadeia que compõe o Marketing de Conteúdo que podem estar as primeiras ocupações profissionais condenadas à substituição ― justamente uma das primeiras a trazer multidões de freelancers para a web. Seria um impacto similar ao de motoristas da Uber sendo substituídos por carros autônomos.

Dada a capacidade de gerar artigos de conteúdo rápido e barato, voltado a dicas, autoajuda, conselhos e instruções superficiais (com botões de call to action para a compra de um curso, que o GPT-3 também pode providenciar), uma grande quantidade de pessoas poderia se ver sem trabalho e renda em um tempo relativamente curto.

Em vez de uma dezena de redatores, como ocorre em agências pequenas, ou de milhares deles, como em grandes plataformas de conteúdo e de trabalho freelancer, algumas poucas pessoas bem treinadas em fornecer boas entradas ao GPT-3 poderiam produzir muitos textos em pouquíssimo tempo. Com alguma automatização a mais, tudo isso estaria na web em minutos, disseminando conteúdo de forma ainda mais massiva do que hoje.

Indo além, a junção de geração de texto com algum mecanismo de text-to-speech e um assistente virtual animado poderia, também em minutos, colocar toneladas de vídeos instrutivos, de propaganda, de conselhos etc., no YouTube, por exemplo.

O maior criador de fake news do planeta?

A futurologia e as implicações acima têm sua outra face danosa: a criação e disseminação ultraveloz de conteúdo preconceituoso, tendencioso, charlatão, mentiroso e outros absurdos mais.

Já há exemplos do que isso é capaz de fazer, mas ainda escalado com conteúdo humano. Como seria uma ferramenta dessas nas mãos de uma quadrilha digital, a mando de uma seita, um grupo terrorista, uma minoria extremista ou mesmo de um governo? Seria a máquina de propaganda de Goebbels escalada exponencialmente? Coloque-se isso nas mãos de dois grupos opositores, mas com mesmas intenções, e ter-se-ia um caos informacional capaz de inviabilizar a web.

Nesse terreno, já temos alguns exemplos malogrados de se tentar usar algoritmos de linguagem natural a quente em redes sociais. Em 2016, a Microsoft lançou a Tay, uma inteligência artificial que tinha objetivo de entreter usuários. Em menos de 24 horas, fustigada por usuários do Twitter, a “robozinha” passou de uma tentativa simpática a uma monstruosidade racista, xenófoba, sexista, capaz de responder que o Holocausto havia sido inventado. Um fiasco que teve de ser retirado do ar.

A produção de artigos científicos, trabalhos acadêmicos e similares também é um campo propício para fraudes.

Vale pensar que modelos como o GPT-3 aprendem de forma similar a uma criança, com exemplos. Como sua base de treinamento abrange todo tipo de conteúdo ― e dada a quantidade de ódio e falsificações existentes web afora ―, não seria uma surpresa se algo tão poderoso escalasse preconceitos.

Surpresa seria o modelo automatizado ter bom senso, mas aí estaríamos presenciando nascimento de consciência, o que seria muito mais fascinante e aterrador. Não é para tanto, ainda.

A OpenAI responde que o objetivo de fornecer acesso ao GPT-3 por meio de API é justamente para prevenir possíveis usos maliciosos, embora não se saiba exatamente como. A instituição também afirma que utiliza pesquisadores terceirizados para estudar o potencial de uso da ferramenta e compreender danos e efeitos colaterais. A Microsoft também vai nessa linha.

Aguardemos o uso de forma lucrativa de um modelo com esse poder (ou de um similar construído em algum lugar com pouca transparência e regulamentação) para conhecermos os próximos capítulos.

Nem tanto à catástrofe...

O medo de novidades é comum, como o de um possível fim do mundo às vésperas de viradas de séculos. O medo de novidades com potencial disruptivo, por sua vez, pode ser muito mais infundado, por causa do desconhecido, ainda mais com escândalos de fake news e desarranjos políticos ocorridos por disseminação de boatos amplificados por algoritmos.

Provavelmente, porém, avanços como o do GPT-3 ganharão mercado de forma gradativa e ainda controlada, até falharem de forma mais engraçada do que desastrosa aqui, serem eficientes acolá, provocarem algum escândalo passível de responsabilização à frente e serem regulamentados à medida que alcançarem maturidade.

Enfim, o ciclo das inovações, como se observa com a tentativa recente de se regular as big techs (Amazon, Apple, Alfabet, dona da Google, e Facebook) por parte de congressistas americanos, depois de pelo menos uma década de euforia (dos 2000 aos 2010) sobre essas empresas.

É possível que, passada uma primeira fase de embates, como a de Uber e taxistas, possa até se tornar desejável o GPT-3 como aliado de profissionais de conteúdo e de desenvolvedores. Afinal, por que repetir tarefas mecânicas se podemos automatizá-las? Não é o que tanto procuramos desde eras remotas?

Em termos mais realistas, a curto prazo, já se fala em custos impeditivos para o uso do GPT-3 fora dos grandes players. Especula-se que a API passaria a ter quatro planos de preços a usuários na versão beta: de gratuito a U$ 400 por mês, este para 10 milhões de tokens (palavras). Escalas maiores dependerão de avaliação da instituição. Cabe lembrar que o modelo completo foi treinado com 499 milhões de tokens, ou seja, usuários terão de usar versões restritas. O fornecimento de acesso por parte da Microsoft poderá ter custos diferentes, certamente. Pelo visto, não será muito viável brincar com todo o poder da tecnologia como pessoa física, o que pode ser ótimo para a segurança (embora não para a inovação, uma conta que nunca fecha).

Falando em Microsoft, uma própria “regulamentação” de mercado pode ser forçada com o tempo, quem sabe por meio de concorrência, pressão para que corporações adotem a ferramenta etc. Quando do anúncio da obtenção da licença do GPT-3 pela Microsoft, Elon Musk, CEO da Tesla, Neuralink e SpaceX ― e um dos membros da equipe fundadora da OpenAI ―, manifestou seu descontentamento. Por meio de um tweet, disse que o licenciamento exclusivo da Microsoft destrói o propósito da OpenAI.

O código fonte do GPT-3, com o licenciamento, ficará sob propriedade da Microsoft. Pode ser uma mina de ouro para a companhia ou, dependendo de seu uso, custos e problemas, também se ver ofuscado com o tempo. (Código aberto, de qualquer forma, nem seria tão viável assim dado o poder de processamento que o GPT-3 requer, segundo a OpenAI, e, de novo, dado suas consequências inimagináveis).

Como toda inovação, o GPT-3 vai mostrar mesmo a que veio quando for posto em batalha. Não será novidade se um dos seus primeiros impactos forem mais cortes de redatores no próprio MSN, da Microsoft (na pandemia, a empresa já substituiu funcionários por software de inteligência artificial para redação e seleção de notícias). E se alguns dos primeiros problemas também saírem de lá, tal como a troca de fotos de cantoras pop em uma notícia sobre racismo, em junho de 2020, também realizada por algoritmos.

Algum buzz, marketing e novos hypes deverão surgir de empresas autorizadas que, baseadas na API, passarem a ofertar o GPT-3 como diferencial em sistemas de chatbots, redação de documentos ou afins. Surgindo algum abuso, como uma campanha de criação de boatos que afete algum contexto político, dada a atenção que isso tem recebido após o caso Cambridge Analytica na eleição de Donald Trump, em 2016, certamente legisladores, reguladores e cidadãos indignados atacarão o GPT-3 como mais uma das bestas do apocalipse destes tempos baseados em aprendizado de máquina e em dados.

E ao ritmo acelerado que o mundo anda, tudo isso pode nem acontecer direito e logo estarmos discutindo o hype do GPT-4, mais poderosa, treinada na Biblioteca de Babel de Jorge Luis Borges e movida a um trilhão de parâmetros ― que, como alguns usuários ousaram calcular, em pouco tempo poderia se aproximar do número de sinapses do cérebro humano, o que pode tornar tudo ainda mais incerto.

Por enquanto, seguem a especulação, mais medos infundados do que benefícios setoriais bem aplicados e uma série de outras dúvidas, como algumas daquelas fundamentais (“a origem de tudo”) para as quais nós e a máquina, que aprende com nossa ignorância, seguimos dando respostas vagas, versões parciais ou retornando cada vez mais cultura pop que inunda a web, como um “quarenta e dois”.

Indo além

Na sequência do GPT-3, a OpenIA criou mais recentemente o DALL-E, um algoritmo que permite criar imagens a partir de textos. É uma junção de dois campos de deep learning, o de Natural Language Processing (NLP) com o de Image Recognition (reconhecimento de imagens). Os exemplos da própria OpenAI mostram que, a partir de texto, o algoritmo é capaz de desenhar um sofá em formato de abacate ou um uma boneca-rabanete passeando com um cachorrinho, por exemplo.

Se você não abriu o link durante o texto, matéria do portal Canal Tech demonstra bem, com ajuda de um desenvolvedor brasileiro, como o GPT-3 funciona. É interessante, como dito no texto, a escolha dos exemplos testados: fake news; “Elon Musk, Grimes e o bebê” (uma fofoca da internet); 5G no Brasil (motivo de briga geopolítica entre EUA e China e alvo de teorias da conspiração), pandemia de Covid e uma música do Wando.

Na Wired, há mais sobre uso do GPT-3 para automatizar a criação de códigos, ou seja, a tal “ameaça” (ou desoneração de atividades chatas e repetitivas) a programadores.

Na revista de tecnologia do MIT, há outro bom apanhado, e bem resumido, sobre a tecnologia. O artigo cita outro experimento interessante, de um bot feito com GPT-3 que respondeu comentários e interagiu no Reddit. Teve até respostas e conselhos a pensamentos suicidas, um aspecto delicado.

Para quem gosta de ir na fonte primária, em vez de ficar em interpretações e visões de alto nível, vale um mergulho no paper técnico do GPT-3. É em inglês e exigente, mas a construção lógica, os avanços observados, desempenho e toda a parte “científica” de criação e testes do algoritmo estão lá.

O fascínio, interesse e temores gerados por essa tecnologia têm continuado e certamente continuarão despejando análises na web. Depois que o algoritmo estiver em produção, como já dito, talvez seja interessante voltar e verificar o que deu certo (realismo) e o que foi otimismo ou pessimismo sem cabimento.

Para refletir e acompanhar: o maior marco do GPT-3 é que ele cria, senão “o” caminho, mas uma forma avançada de fazer a máquina interagir com a linguagem humana, o que pode abrir portas para uma série de avanços, os quais podem afetar desde processos de negócios (falar, em vez de apertar botões ou escrever, como fazemos hoje) à própria programação das máquina (ordenar o que deve ser feito, de forma humana, e não ter de programar explicitamente).

Artigo escrito por Rogério Kreidlow, jornalista, que gosta de observar a tecnologia em relação a temas amplos, como política, economia, história e filosofia.

Optamos por usar GPT-3 no masculino, por causa de sua denominação (Generative Pre-trained Transformer 3) e em referência a “algoritmo” ou “modelo de deep learning”. Há outras publicações que o citam no feminino, em referência à “Inteligência Artificial GPT-3”, por exemplo. Não parece haver convenção formada.

O paper que descreve o algoritmo é de 28 de maio de 2020.

Não há valor real divulgado. O que há são estimativas com base nos custos de nuvens, como é discutido neste tópico do Reddit. Há publicações que citam US$ 12 bi e há as que citam R$ 4,6 bi, muitas delas sem citar fontes.

Temos um texto sobre No-code em outra newsletter da Awari. Apesar dele ser mais voltado a Product Management e UX Designers, também fala sobre machine learning sem código, o que pode ser interessante à Ciência de Dados.