Devemos muito aos Testes A/B

Como experimentos simples abriram portas para decisões baseadas em dados nos negócios. E como sua popularização revelou o quanto há de Estatística por trás de comparações aparentemente banais

O ditado popular “quando cheguei, era tudo mato” se aplica bem aos Testes A/B nos primórdios da Internet comercial. Quando a rede ainda era um matagal, desbravada pelas primeiras empresas data-driven, principalmente as atuais big techs, como Google, nos anos 2000, testes A/B já se anunciavam como uma “praga” tomando conta da floresta.

“Praga”, aqui, não no sentido bíblico ou do dicionário, de maldição ou flagelo. Mas, sim, como algo capaz de se replicar a ponto de se tornar um componente fundamental do ecossistema.

Testes A/B fizeram muito pela qualificação da Internet, do aspecto visual à usabilidade de sites e aplicativos, das campanhas de marketing às otimizações de software — e a Ciência de Dados deve muito a eles por isso. Se a relação não é óbvia, vamos contextualizar o raciocínio.

Os Testes A/B foram pioneiros para que uma mentalidade científica ganhasse espaço nos negócios movidos a tecnologia. Eles proporcionaram contato com raciocínio analítico a pessoas de domínios pouco quantificados, como o marketing e o design, por exemplo.

Aos poucos, a técnica incentivou a rever decisões fundamentadas apenas em opiniões subjetivas e intersubjetivas. Ajudou a promover honestidade intelectual, de que podemos estar redondamente enganados em nossas crenças e intuições.

Ou, como diria o estatístico William Deming, em uma frase célebre, muito citada em empresas baseadas em experimentos:

“Em Deus, nós confiamos. Todos os outros, tragam dados” — William Deming.

Consequentemente, adotamos um ceticismo baseado em evidências, de que só podemos ter mais confiança sobre fenômenos se sairmos de nosso umbigo, olharmos com abertura às externalidades e nos dispormos a medir a realidade com rigor estatístico.

Com a repetição de experimentos e, principalmente, com os erros advindos da falta de conhecimento estatístico, passou-se a enxergar as nuances, implicações e armadilhas que simples comparações de performance entre a cor de botões ou posicionamentos de banners traziam embutidas.

E as percepções não ficaram restritas à estética de sites e apps ou à perfumaria tecnológica. Tiveram o poder de impactar pessoas de negócios, que vivem preocupadas com receitas acima de tudo.

Os testes permitiram enxergar que, de pequenas em pequenas otimizações, aquisição, retenção e engajamentos de clientes poderiam ser aprimoradas quase à perfeição. Para empresas que atuam em escala, comparações simples, aparentemente banais, entre versões de um site ou aplicativo, tinham o poder de trazer milhões ao caixa.

No extremo, isso levou até uma tendência interessante: se podemos medir quase tudo a fim de ganhar mais, significa que estamos perdendo tempo — e dinheiro — se não implementarmos testes para tudo o que for possível.

A partir dessa perspectiva, fica fácil entender por que testes A/B impregnaram a indústria de tecnologia e preparam bases para que abordagens quantitativas mais robustas, onde Data Science entra em cena, ganhassem espaços nos negócios. Cases cimentam ainda mais o raciocínio.

Como a moda pegou

Era 27 de fevereiro de 2000, ou seja, há mais de 20 anos, quando engenheiros do Google realizaram o primeiro teste A/B da empresa. O objetivo: verificar se os 10 resultados por página, apresentados pelo mecanismo de busca, eram ideais aos usuários. O experimento: 0,1% do tráfego visualizaria 20 resultados, outro 0,1%, 25, outro, 30.

O teste começou com uma falha técnica, entretanto. O tempo de carregamento para os grupos experimentais (20, 25 e 30 resultados) estava maior que o do grupo de controle (10 resultados), o que, mesmo assim, gerou uma primeira conclusão positiva: décimos de segundo a mais afetam negativamente a experiência do usuário.

A falha foi corrigida e, enfim, não se rejeitou a “hipótese nula”: os dez resultados que já eram exibidos eram, de fato, considerados ideais.

Onze anos depois, o Google realizava mais de 7 mil experimentos do tipo em seu algoritmo de pesquisa. Pelo jeito, os 10 resultados se mantiveram desejados (embora possam ter habituado os usuários a preferi-los, o que interfere na própria opção).

A história toda é narrada em reportagem da Wired, “The A/B Test: Inside the Technology That's Changing the Rules of Business” (“O Teste A/B: Por Dentro da Tecnologia que está Mudando as Regras de Negócios”), de 2012.

A empolgação em torno do assunto (e da tecnologia em geral) era grande na época, como se pode perceber pelo tom e pelas declarações. Era como se uma nova era tivesse se pronunciado a partir de comparações tão simples.

A quantidade crescente de dados e a velocidade de processamento, que permitia testes mais rápidos, levou a uma automatização sem precedentes de decisões baseadas em evidências.

A reportagem também cita o caso da campanha de Obama, em 2008, pioneira no uso de ferramentas digitais. Por meio de testes A/B, ao fim da disputa, estimou-se que quase um terço dos 13 milhões de e-mails cadastrados e cerca de 75 milhões de dólares arrecadados pelo Partido Democrata só foram possíveis por causa de experimentos A/B.

Eles foram realizados por Dan Siroker, um ex-Google, que se licenciou da empresa na época para ser consultor digital de Obama. Após a vitória nas urnas, Siroker fundou a Optimizely, uma das tantas ferramentas que hoje inundam o mercado e que popularizaram os testes A/B entre pessoal não técnico.

Os sucessos atingidos e os fracassos evitados abundam em exemplos. Entre 2009 e 2010, o Bing comprovou que links que abriam em uma nova guia do navegador aumentavam o engajamento dos usuários.

Em 2012, o mesmo Bing gerou 12% a mais de receita por aplicar testes A/B para decidir quais títulos de anúncios eram melhores — hoje, grandes empresas de mídia aplicam testes multivariados para testar qual a melhor opção entre dezenas ou centenas de sugestões de títulos.

Para desespero de um designer, o Google chegou a testar 41 tons de azuis, entre dois tons de azuis iniciais, para decidir qual tornava links mais atraentes. O experimento, aparentemente detalhista e inofensivo, teria rendido 200 milhões de dólares a mais por ano à empresa.

O fundador da Amazon, Jeff Bezos, a pessoa mais rica do mundo na atualidade, é conhecido por ter estabelecido uma cultura de experimentação feroz na empresa desde seu início, em 1994. Em uma de suas cartas a acionistas, declarou:

“Para inventar você tem que experimentar, e se você sabe de antemão que vai funcionar, não é um experimento. A maioria das grandes organizações abraça a ideia da invenção, mas não está disposta a sofrer a série de experimentos fracassados necessários para chegar lá.” — Jeff Bezos.

É fato. As big tech, como Google, Facebook e Amazon, e as grandes disruptoras posteriores, como Uber, AirBnb e Netflix, entre outras, foram pensadas por meio da mentalidade de experimentos e construídas sobre testes A/B.

Talvez resuma-se aí o âmago de toda a inovação, que tirou a tomada de decisão de cabeças criativas ou de cargos altos — o apelido jocoso para essas pessoas, em inglês, é “HiPPO” (“Highest Paid Person’s Opinion” ou, em tradução livre, “Opinião da Pessoa Mais Bem Paga”) — para colocá-la nas mãos impessoais da Estatística.

A “praga”

A moda pegou. De repente, tudo passou a ser teste A/B na tecnologia, principalmente no design de sites e apps, nas campanhas de marketing e no desempenho de software. Se as big techs e startups do Vale do Silício diziam, era um “santo graal” da inovação e todos tinham que adotar a prática.

As ferramentas prontas se multiplicaram com o hype. Davam a impressão de tornar testes A/B tão banais como reparar macarrão instantâneo. As calculadoras de tamanhos de “amostras”, “significância estatística” e outros termos parecidos com aqueles que ouvimos nas notícias sobre pesquisas eleitorais multiplicaram-se na web.

Toneladas de guias, tutoriais e listas de como fazer experimentos em 5, 7 ou 9 passos (o de cinco passos deve ser mais fácil, acreditaria um desavisado) ajudaram a educar sobre o tema, mas também deram a impressão de que você poderia usar testes A/B até para quando estivesse indeciso entre um café ou capuccino no intervalo do tarbalho

Os resumos são todos mais ou menos parecidos, com exemplos que normalmente tratam da cor ou posicionamento de um botão ou banner em uma página.

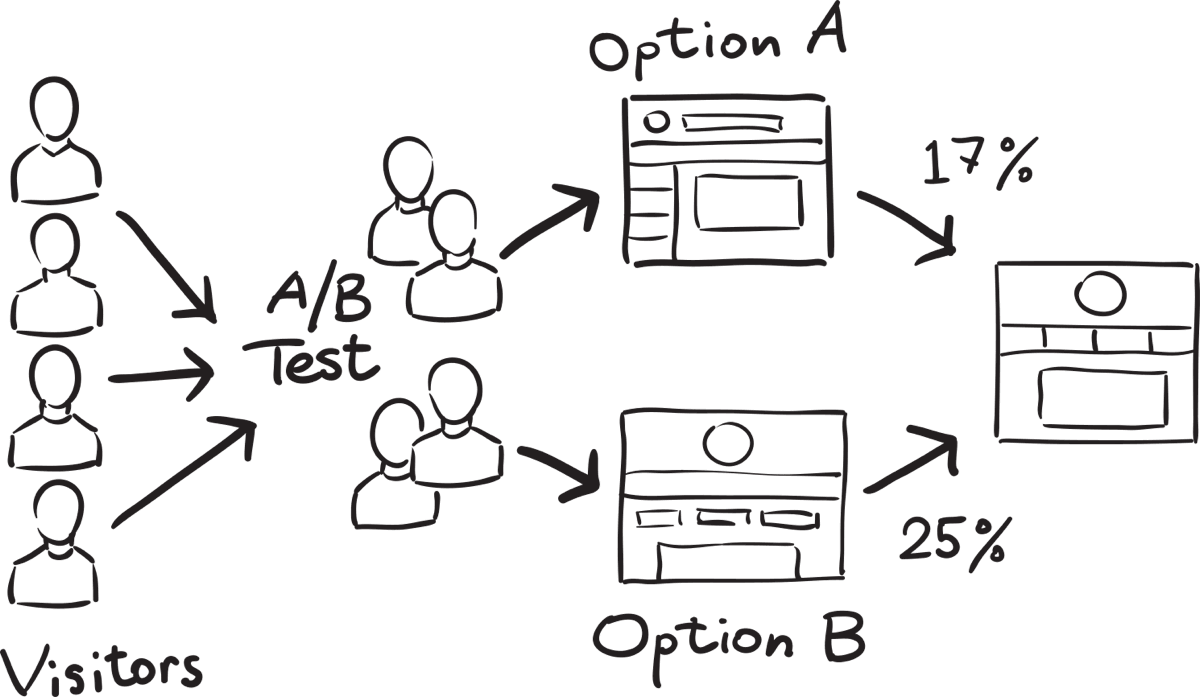

Um tutorial típico resumirá que “basta” você dividir os usuários que estão acessando o site ou aplicativo, direcionar uma parte para ver o botão azul, já usado atualmente (a versão “A” do teste), e fazer com que a outra parte veja o botão vermelho, a versão “B” do teste — que você supõe, talvez por vermelho ser uma cor quente, que irá atrair mais cliques. Você deixa um tempo rodando e, ao final, vê qual botão foi mais clicado. “E está pronto seu teste A/B”.

A aparência de facilidade misturou crenças e vieses pessoais com estatística superficial, fez muitos testes serem parados ao atingir o que se acreditava (após dois dias, o botão vermelho tinha 20% a mais de cliques, então, nada de perder tempo: ele podia ser implementado em produção a todos os usuários).

Por causa dos testes A/B, muita gente se sentiu como se estivesse fazendo ou entendendo até as pesquisas eleitorais citadas. “Margem de erro” (de 1 a 2 pontos percentuais para mais ou para menos), tamanho da amostra (1.650 pessoas ouvidas entre determinadas datas) e nível de confiança (95%) pareciam óbvias.

Até o processo de se testar eficácia e segurança de vacinas, como a da Covid, podiam ser explicadas por testes A/B. Afinal, havia um grupo de “controle” (que recebia um placebo ou nenhum tratamento) e um grupo de “tratamento” (que recebia a vacina). A comparação permitia saber se ela imunizaria os pacientes e se teria efeitos colaterais aceitáveis. Acrescentariam-se alguns conceitos como “duplo-cego” ao experimento e, abracadabra, testes A/B desmistificavam até ciência de ponta.

Ironias à parte, há alguns exemplos básicos interessantes na web que ajudam a entender testes A/B de forma bastante intuitiva, a quem procura uma primeira visão introdutória, longe de Estatística avançada ou de ferramentas da Ciência de Dados.

O blog da Resultados Digitais, empresa que fornece solução de marketing ao mercado, dá alguns exemplos simples de experimentos que realizou na prática. Alguns dos casos citados são:

uma landing page gerou conversão 27% maior que uma versão original;

a inserção de botão de call-to-action antes do texto de mensagem de e-mail trouxe 24,28% a mais de cliques do que versão que continha o botão após o texto;

entretanto, colocar um vídeo de autor em um material educativo, acreditando-se que aumentaria em 20% a taxa de conversão, acabou demonstrando o contrário: a versão com o vídeo diminuiu-a.

A Optimizely, já citada, tem bons tutoriais de A a Z que ajudam com uma visão geral, por exemplo. Outras das ferramentas prontas têm bibliotecas parecidas com instruções e dicas honestas.

Elas, inclusive, são uma ótima porta de entrada a quem quer ser introduzido à Estatística que se escondem nos bastidores dos testes A/B, como a Inferência Estatística, com seus testes de hipóteses (e as terminologias deste, como hipótese nula, p-valor, erros do tipo I e II) e design de experimentos.

Então, justamente por falta de conhecimento estatístico, chegaram as consequências. A empresa acreditava que posicionar o botão de call-to-action na parte superior do site e não na parte inferior, onde já estava, geraria muito mais conversões de compras. Implementou um teste com o botão no alto. A versão rejeitou a “hipótese nula”, ou seja, o botão na parte inferior. Sucesso!

Quando o botão na parte superior foi colocado em produção, o inesperado: cliques e conversões misteriosamente caíram, contrariando os testes. Os canais de atendimento ao cliente foram inundados com reclamações sobre a mudança do botão. Uma enxurrada deles exigia o botão na parte inferior de volta.

O que havia dado errado? Testes A/B não eram essa bala de prata toda? A ferramenta de testes, comprada por um preço considerável, estava com problemas? Os usuários (essa é clássica) mais uma vez não sabiam o que queriam?

Em casos mais desastrosos, dinheiro de campanhas de marketing foram para o ralo, aplicativos deixaram de funcionar, usuários debandaram para concorrentes, mudanças viraram memes e fúria (como os posts na horizontal do Instagram, há alguns anos), por desconhecimentos das armadilhas estatísticas infiltradas no testes.

As armadilhas

Outra tonelada de conteúdo passou a ser publicada na web após uma certa “ressaca” da popularização dos testes A/B. Eram escritos, em geral, por pessoas mais calejadas na lida estatística, cansados de ter de raciocinar e intuir muito além dos cálculos, ao montar experimentos e interpretar resultados. O mundo, afinal, é muito mais complicado e menos óbvio do que se imagina.

A maioria desses conteúdos alerta que os testes A/B são feitos, em sua maioria, de forma equivocada, por uma série de motivos que podem parecer “papo de especialista” a quem não é do meio:

porque não há “significância estatística” (diferença entre uma hipótese, a suposição de que usuários querem o botão vermelho, em relação ao comportamento observado no experimento);

porque as amostras (usuários que fizeram os testes) não são representativas da população (todos os usuários reais que usam a solução), algo mais ou menos como entrevistar só pessoas de classe alta para tentar entender a renda da população brasileira;

porque a pressa fez o experimento ser interrompido quando atingiu o valor esperado (viés de confirmação) e não quando atingiu a amostra estatisticamente necessária;

porque o intervalo de confiança está abaixo de 95%, uma medida de quão próximo uma amostra (usuários que participaram do teste do botão) está da população (todos os usuários que utilizarão o site ou aplicativo).

Outras problemas estão fora da Estatística, como, por exemplo:

o produto está em fase inicial e tem uma base muito pequena e volátil de usuários, cujo comportamento pode mudar de forma drástica em pouco tempo;

as hipóteses a serem testadas são vagas demais;

querer testar muita coisa ao mesmo tempo, por exemplo, querer comparar duas versões de um app inteiro de uma só vez — há os testes multivariados, já mencionados, mas eles são mais complexos e requerem mais cuidados;

há má qualidade nos dados capturados durante o teste, isto é, não captam precisamente o comportamento que está se tentando verificar;

as pessoas que elaboram e interpretam os testes não percebem seus próprios vieses cognitivos, o que pode levá-las a querer confirmar uma suposição a todo custo (fazer os dados dizerem o que desejam) ou superestimar ou subestimar resultados, procurando motivos laterais para qualificar ou desqualificar os testes.

Um artigo intitulado “A/B Testing Statistics: An Intuitive Guide For Non-Mathematicians” (“Estatísticas em Teste A/B: Um Guia Intuitivo para Não Matemáticos”) ajuda a ter uma percepção, como o título diz, mais “intuitiva” das particularidades estatísticas, apesar delas requerem, em geral, um bom processo de raciocínio e treino para serem apreendidas de fato.

Outro artigo, intitulado “10 Statistics Traps in A/B Testing: The Ultimate Guide for Optimizers” soma mais algumas percepções.

O problema, grosso modo, é que ferramentas, calculadoras ou até bibliotecas de código que permitem implementar fórmulas para testes A/B mostram o que é óbvio e necessário à prática, mas deixam de fora um sem número de nuances da realidade que podem tornar um experimento impreciso ou incorreto.

Isso exige ir além dos testes e mergulhar em Estatística ou práticas científicas mais profundos, para não se cair em equívocos ingênuos, o que naturalmente toma tempo, dá trabalho e não é possível de aprender e realizar em um estalar de dedos.

Obviamente, não é preciso aprender toda a Estatística que há por trás dos testes, até porque seria impossível, mas é necessário ter disposição e curiosidade para aprender gradativamente à medida em que se pensa sobre e se pratica os próprios testes. Os erros ou descuidos, inevitavelmente, também servem como boas fontes de aprendizados.

Ao contrário do que tutoriais mais básicos tentam resumir ao extremo, não há fórmulas em 5, 7 ou 9 passos que permitam declarar: “sei tudo sobre testes A/B, basta aplicar isso e aquilo, não preciso de mais nada”.

Essa disposição para aprendizado é necessária, também, por outro motivo. À medida que startups crescem e escalam seus negócios, a busca por automação aumenta, o que significa implementar machine learning para fazer o trabalho repetitivo e pesado do negócio.

Como testes A/B em massa são o feijão com arroz da indústria de tecnologia, chegará a hora em que será mais eficiente fazê-los por meio de algoritmos de aprendizado de máquina do que por meio de ferramentas prontas ou de forma pontual e um tanto manualizada. No máximo, serão dados os inputs e verificados os resultados, mas toda a lógica estatística e de negócio terá de ser implementada em algoritmos.

Um artigo do blog de Data Science do Booking — outro pioneiro no uso de testes A/B para quase tudo — mostra como a empresa usou Séries Temporais e Inferência Bayesiana para experimentos não aleatórios, onde testes A/B não eram viáveis, mesmo a empresa tendo desenvolvido uma plataforma própria para testes em escala.

Uma solução mais avançada como essa demanda muito conhecimento do público que utiliza o serviço do Booking, de toda a Estatística por trás dos testes A/B, da própria ferramenta utilizada na empresa e como construir saídas possíveis com outras técnicas estatísticas, como a Estatística Bayesiana.

Chega-se a esse nível após muito tempo debruçado sobre o negócio, os dados do comportamento dos usuários e reflexões sobre o que a plataforma interna, certamente bastante avançada, ainda não contempla.

Outros artigos detalham aprimoramentos na plataforma interna de testes em relação à complexidade de públicos do Booking, onde testes A/B simples podem adaptar o produto a um determinado tipo de viajante (de negócios, no caso) e piorá-lo para o grupo maior de clientes.

A quem tiver um pouco mais de curiosidade filosófica, além de algum tempo a perder, é possível descobrir até as brigas de Zerzy Neymann e Egon Pearson, filho de Karl Pearson, um dos “pais” da Estatística, contra Ronaldo Fischer, outro “pai”, em torno de modelos de inferência estatísticas.

Além disso, há discussões profundas sobre testes de hipóteses e queixas avançadas de que eles (em que os testes A/B se fundamentam) são até uma ilusão de certeza — o tópico da Wikipedia em inglês dá uma noção disso.

Não é necessário para a estatística do dia a dia chegar a abismos, mas histórias como essas dão uma noção dos pontos a serem descobertos e daqueles ainda em aberto, aos quais simples testes com botões coloridos podem levar.

Oportunidades

O que tudo isso significa a aspirantes ou a cientistas de dados já no mercado? Que a popularização dos testes A/B tirou-os das mãos de quem mais entende de Estatística? Que está tudo perdido mesmo com a popularização? É claro que não. Significa oportunidades de qualificar e contribuir com rigor e educação para os experimentos.

A Ciência de Dados deve muito aos testes A/B porque, como dito, eles pavimentaram a estrada para que uma mentalidade analítica, quantitativa, conduzida por experimentação e baseada em evidências ganhasse espaço no mundo dos negócios.

Os cientistas de dados são os melhores “consultores” para aplicar a prática e levar a essa mentalidade em empresas iniciantes. Nessas organizações, auxiliar a realizar e interpretar pequenos experimentos de UI design ou de marketing pode ser mais relevante do que conhecimentos em algoritmos avançados de machine learning, em um primeiro momento.

Em startups em crescimento ou negócios maduros em tecnologia, as oportunidades estão em auxiliar no desenvolvimento, aprimoramento e uso de plataformas de testes, como as que permitem à Netflix, ao Uber, ao Booking ou ao AirBnb conhecerem nuances cada vez mais refinadas de seus mercados e se manterem relevantes neles.

Em empresas como essas, o foco já não está em realizar experimentos pontuais, isolados e independentes, mas em utilizar a gama de dados que captam para análises integradas por meio de soluções automatizadas. Ou seja, aqui cabem soluções de aprendizado de máquina capazes de realizar muitos testes simultâneos e que simplificam os resultados e insights.

Um artigo de 2016 no blog da Netflix, longo e detalhado, mostra um pouco da plataforma de testes que a empresa usa. De algoritmos de transmissão e entrega de conteúdo a personalização da tela que assistimos, praticamente tudo no produto passa por testes A/B.

O texto comenta, por exemplo, em aumentos de 20% a 30% em visualizações de determinados filmes ou séries, decorrentes de opções comparadas por meio de testes.

O blog do Airbnb também traz relatos similares. Em um deles, de 2014, o autor diz que existiam recursos no negócio que tornavam a experimentação muito mais necessária do que decidir a cor de botões, o que levou a empresa a construir sua própria estrutura de experimentação.

Uma vantagem da plataforma é que ela não só ajuda os experimentos como é ajudada por eles. Por meio de erros ou comportamentos contra intuitivos percebidos nos testes, a plataforma é aprimorada para ser mais assertiva em novos experimentos — um tipo de produto interno que requer Ciência de Dados e que entrega muita vantagem ao negócio.

Um artigo replicado no KDnuggets, em 2021, de uma cientista e engenheira de dados também do AirBnb, é uma aula sobre o nível de proficiência em testes A/B que essas empresas procuram em candidatos.

A abordagem é longa, pode ser densa ou até intimidadora a quem está iniciando, mas contém ótimos insights sobre o raciocínio e a intuição que vale a pena desenvolver para se tornar um especialista nesses experimentos.

Mais do que por meio de grandes tacadas de mestres ou genialidades, é por meio de milhares pequenos testes A/B que grandes empresas de tecnologia se consolidaram e hoje estão entre as mais importantes e valiosas do mundo.

Devemos muito a uma infinidade de microtestes, alguns até banais, mas que em conjunto entregam um poder enorme de conhecer e agir sobre a realidade como nunca antes. E a Ciência de Dados é a mais qualificada a levar rigor aos testes, a desenvolver e manter plataformas que permitam democratizá-los de forma eficiente e correta nas empresas, além de ajudar pessoas de negócio a conduzir experimentos e interpretar resultados sem cair nas armadilhas citadas.

Artigo escrito por Rogério Kreidlow, jornalista, que gosta de observar a tecnologia em relação a temas amplos, como política, economia, história e filosofia.